To oczywiście w teorii. Ja w dzisiejszym wpisie skupiając się na możliwościach Duet AI w BigQuery będę starał się odpowiedzieć na pytanie – jak to wygląda w praktyce.

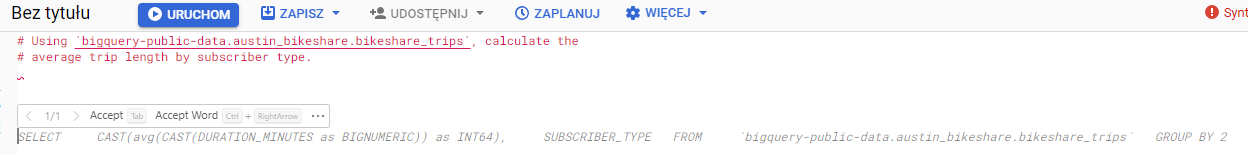

Po kliknięciu Spacji lub klawisza Enter, Duet Ai tworzy dla nas rekomendacje zapytań, z których możemy wybrać te odpowiadające najbardziej naszej potrzebie a następnie zatwierdzić je klawiszem TAB.

# Using `bigquery-public-data.austin_bikeshare.bikeshare_trips`, calculate the

# average trip length by subscriber type.

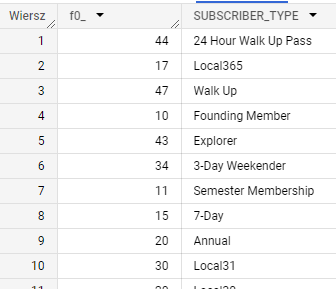

subscriber_type i duration_minutes podczas gdy w prompcie przekazujemy mu prośbę o policzenie average trip length by subscriber type

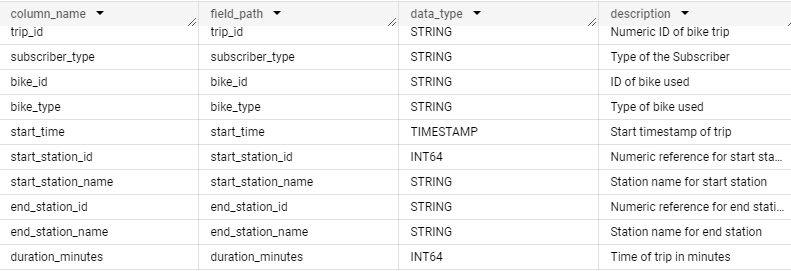

Dla odmiany teraz popracuję z datasetem nie zawierającym opisów kolumn więc Duet Ai będzie zmuszony domyślać się o co mi chodzi tylko i wyłącznie na podstawie nazw kolumn.

# Using `primal-monument-358918.thelook_ecommerce` calculate the

# total number of orders and total revenue broken down by day of the order

SELECT

DATE(_PARTITIONTIME) AS date,

COUNT(*) AS num_orders,

SUM(sale_price) AS total_revenue

FROM

`primal-monument-358918.thelook_ecommerce.order_items`

GROUP BY

date

Zapytanie zawiera dwa znaczące błędy. Po pierwsze Tabela nie jest partycjonowana po polu daty więc zwraca błąd Unrecognized name: _PARTITIONTIME at [4:8], po drugie count(*) z tabeli order_items policzy nam wszystkie zamówione przedmioty a nie zamówienia. Przychód policzył najbardziej poprawnie.

# Using `primal-monument-358918.thelook_ecommerce.orders` and `primal-monument-358918.thelook_ecommerce.order_items` and `primal-monument-358918.thelook_ecommerce.products` and #`primal-monument-358918.thelook_ecommerce.users`,

# create following table: Dimensions: Day, Product Name,Order ID, Users Name and Surname, User Email, Metrics : Count of Products ordered, Revenue Of Products ordered

# For Day use created_at field from `primal-monument-358918.thelook_ecommerce.order_items` Table,

# For Order ID use order_id field from `primal-monument-358918.thelook_ecommerce.order_items` Table,

# For Product Name use name field FROM `primal-monument-358918.thelook_ecommerce.products` Table

# For User Name use first_name field FROM `primal-monument-358918.thelook_ecommerce.users` Table,

# For User Email use email field FROM `primal-monument-358918.thelook_ecommerce.users` Table,

# For Count of Products Ordered use Product_Id FROM `primal-monument-358918.thelook_ecommerce.order_items` Table,

# For Revenue use Product_Id FROM `primal-monument-358918.thelook_ecommerce.order_items` Table

SELECT

DATE(T1.created_at),

T2.NAME,

T3.FIRST_NAME,

T3.LAST_NAME,

T3.EMAIL,

CAST(count(*) as BIGNUMERIC),

sum(T1.SALE_PRICE)

FROM `primal-monument-358918.thelook_ecommerce.order_items` AS T1

INNER JOIN

`primal-monument-358918.thelook_ecommerce.products` AS T2

ON T1.PRODUCT_ID = T2.ID

INNER JOIN

`primal-monument-358918.thelook_ecommerce.users` AS T3

ON T1.USER_ID = T3.ID

GROUP BY 1, 2, 3, 4, 5

Dla mnie najważniejsze jest to, że w ogóle działa.

Nie będę ukrywał, nie Cierpię pisać zapytań SQL. Od dawna czekałem aż będę mógł tworzyć gotowe widoki pisząc lub idealnie, mówiąc do maszyny, która zrobi to za mnie tak abym ja mógł się skupić na analizie, wizualizacji i wyciąganiu wniosków z moich danych biznesowych.

Hybrid Poplar Sp. z o.o.

VAT ID: PL5213892597

ul. Ksawerów 3,

02-656 Warszawa

Copyright © 2024 bigglo | Wszelkie prawa zastrzeżone.

Hybrid Poplar Sp. z o.o.

VAT ID: PL5213892597

ul. Ksawerów 3,

02-656 Warszawa

Copyright © 2024 bigglo.pl

Ustawienia plików cookies

Informacje o plikach cookies

Szanujemy Twoją prywatność